新的AI模型,将GPU用量降低100倍

作者:admin 来源:半导体行业观察 发布时间:2024-01-31 访问量:1225

在市场将索伦之眼转向 GenAI(例如 ChatGPT)之前,传统神经网络受到了大部分关注。这些类型的神经网络的特点是具有一些“短期”记忆,称为循环神经网络或 RNN。它们在 Apple Siri 或 Google Translate 等许多“智能”技术中继续使用,并且绝不过时。

最近,一篇新发表的,题为《RWKV: Reinventing RNNs for the Transformer Era》的论文描述了一种具有 GPT 级别 LLM 性能的 RNN,它也可以像 GPT Transformer(可并行化)一样直接训练,计算要求降低 10 到 100 倍。(即更少的 GPU)。

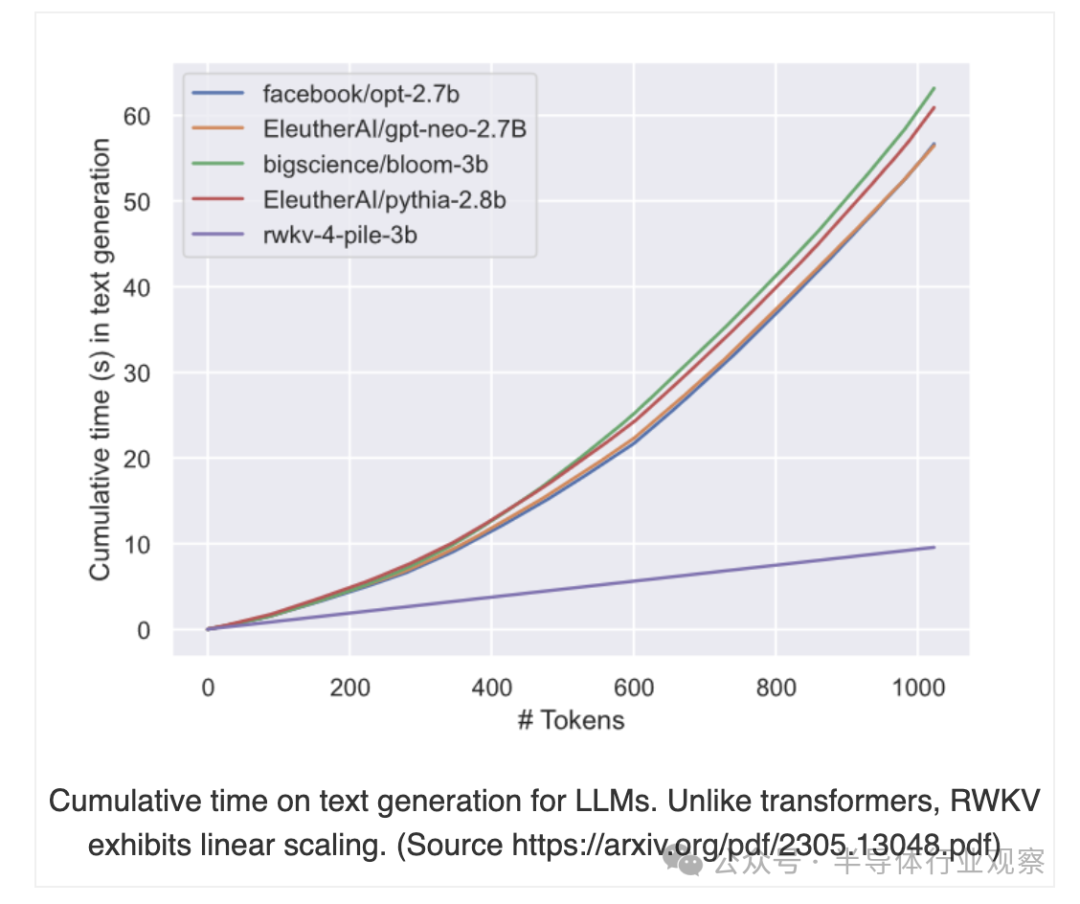

该论文描述了像 ChatGPT 这样的转换器如何彻底改变了几乎所有自然语言处理 (NLP) 任务,但却受到内存和计算复杂性的影响,这些复杂性与序列长度呈二次方关系(即,向模型添加更多内容,将需要更多内容平方更多的计算资源)计算)。

相比之下,循环神经网络 (RNN) 在内存和计算要求方面表现出线性扩展(即,向模型添加更多内容,将占用成比例/线性数量的计算资源)。然而,由于并行化和可扩展性的限制,RNN 很难达到与 Transformer 相同的性能。

本文提出了一种新颖的模型架构——接收加权键值(RWKV:Receptance Weighted Key Value),它将 Transformer 的高效并行训练与 RNN 的高效推理相结合。

初步结果相当惊人。从积极的一面来看,RWKV 方法提供了:

运行和训练时降低资源使用率(VRAM、CPU、GPU 等); 与具有大上下文大小的转换器相比,计算要求降低了 10 倍到 100 倍; 线性缩放到任何上下文长度(Transformer 以二次方缩放); 在回答质量和能力方面表现同样出色; 与大多数现有模型相比,模型通常可以更好地用其他语言(例如中文、日语等)进行训练; RWKV 模型当前面临的一些挑战是:

对提示格式敏感;您可能需要更改提示模型的方式; 它在需要回顾的任务上较弱,因此相应地重新排列提示(例如,不要说“对于上面的文档,执行 X”,这将需要回顾。而是说“对于下面的文档执行 X”) ); RWKV ( wiki ) 也是 Linux 基金会下一项开源、赞助商支持的非营利项目。他们的目标是结合最好的 RNN 和 Transformer 技术,包括出色的性能、快速推理、训练、VRAM、“无限”上下文长度和自由句子嵌入; 此外,与 LLM 不同,RWKV 100% attention-free。 RWKV 等项目的影响是巨大的。RWKV 模型不需要购买(租用)100 个 GPU 来训练 LLM 模型,而是可以以不到 10 个 GPU 的成本提供类似的结果。 HuggingFace 上提供了预训练、微调的 7B 世界模型(在更大、更多样化的数据组合上训练的基本模型,其中包括来自 100 多种语言的样本,并且经过部分指令训练。)

上一篇:几何相位编码的液晶光学传感

下一篇:室温超导意味着什么

上海市智能制造产业协会

上海市智能制造产业协会 上海市集成电路行业协会

上海市集成电路行业协会 华东理工大学

华东理工大学